- A+

一、初识 Magnet:“相关度”指标究竟是什么?

在探索 Magnet 系统的旅程中,我们首先遇到的基石便是“相关度”指标。它并非一个模糊的概念,而是整个系统智能决策的核心。理解它,是掌握 Magnet 强大能力的起点。

1. 破除迷思:相关度不止是关键词匹配

传统搜索可能仅满足于关键词的出现频率,但 Magnet 的“相关度”是一个更为精妙的量化评估体系。它并非简单地计算词语匹配度,而是为每一个内容项(如文章、商品或用户)计算出一个综合分数。这个分数的唯一目的,就是预测该内容与用户当前需求或查询的契合程度,从而实现精准排序,将最符合预期的结果置于顶端。它衡量的是“匹配的质量”,而非“匹配的数量”。

2. 解构核心:多维度的信号融合

这个看似神奇的综合分数,其本质是多维度信号的加权融合。Magnet 的算法会同时考量多种因素,例如:内容信号,通过自然语言处理(NLP)分析文本的语义相似度,而不仅仅是字面匹配;用户行为信号,如点击率(CTR)、页面停留时长和用户的历史偏好数据;时效性信号,偏爱更新鲜的内容;以及社证信号,如点赞、分享和评论数。每种信号都被赋予不同的权重,这些权重的组合与动态调整,正是 Magnet 系统的“秘方”,决定了最终排序的优劣。

3. 指标的价值:驱动体验与增长

为何要如此精密地计算“相关度”?因为它直接决定了用户体验与商业价值的上限。一个高相关度的推荐或搜索结果,能让用户迅速找到所需,感受到“系统懂我”的智能,从而提升满意度和粘性。对于平台而言,这意味着更高的用户参与率、转化率和留存率。可以说,“相关度”指标是 Magnet 区别于平庸系统的根本,是驱动其持续优化、创造价值的核心引擎。

二、为何“相关度”是关键词筛选的黄金标准?

1. 匹配搜索意图:流量的精准基石

相关度的首要价值在于对用户搜索意图的深度匹配。用户输入关键词,背后隐藏着一个明确或潜在的目标:寻求信息、比较产品、或准备购买。一个高相关度的关键词,如同精准的导航,能将用户直接引导至满足其意图的内容页面。反之,若关键词与内容貌合神离,即便获得排名,带来的也是无效流量。用户点击后发现文不对题,会迅速跳出,这种“pogo-sticking”行为会向搜索引擎传递负面信号,损害网站权威性,最终导致排名下滑。因此,相关度是构建用户信任与搜索引擎信任的基石,它决定了流量的质量而非仅仅是数量。

2. 驱动有效转化:超越点击的商业价值

流量的终极目标是转化,而相关度是实现转化的催化剂。一个搜索“B2B企业CRM系统推荐”的用户,其商业意图远强于搜索“什么是CRM”的用户。如果内容精准地围绕前者展开,提供详尽的对比分析、案例研究,并自然地植入产品信息,那么从访客到销售线索的转化路径将极为顺畅。高相关度意味着内容与用户需求的高度共鸣,这种共鸣能建立专业信赖感,大幅降低决策成本。它将SEO从单纯的“引流”工程,提升为驱动商业增长的精密引擎,确保每一次点击都有可能沉淀为实实在在的商业价值。

三、解读 Magnet 界面:定位“相关度”数据列

1. 核心指标——“相关度”的算法逻辑

“相关度”并非简单的关键词匹配度,而是一个多维度的综合性语义评分系统。其算法核心通常融合了三大权重。首先是语义相似性,系统通过自然语言处理(NLP)模型,如BERT或Word2Vec,深度理解查询目标与候选条目在向量空间中的距离,距离越近,语义关联越强。其次是主题一致性,算法会评估条目内容是否在主题层面与用户的宏观目标保持一致,例如,一个条目可能包含关键词,但其核心主题若偏离,相关度得分会显著降低。最后是用户意图匹配,高级的Magnet系统会结合用户过往行为、查询上下文等因素,预测其潜在意图,并据此调整相关度权重。因此,“相关度”得分越高的条目,代表其不仅在字面上,更在深层含义、主题归属和潜在价值上与用户的需求高度契合。

2. 策略罗盘——为何“相关度”是决策关键

在信息爆炸的时代,注意力是最稀缺的资源。“相关度”数据列就如同一座精准的罗盘,指引我们在数据的海洋中航行。首先,它充当了高效的信息过滤器。面对成千上万的条目,用户无需逐一阅读,只需依据相关度从高到低排序,就能在几秒钟内锁定最核心、最有价值的候选集,极大地提升了工作效率。其次,它是资源分配的依据。无论是进行内容营销、竞品分析还是技术选型,将有限的资源(时间、预算、人力)投入到高相关度的目标上,意味着更高的投资回报率。例如,在内容创作中,优先围绕相关度90%以上的热点和问题进行布局,能更快地获得精准流量。最后,“相关度”是验证方向的标尺。当用户提出一个新的市场假设时,高相关度的数据结果能有力支撑该假设的可信度,反之则提示需要调整或重新评估方向。

3. 实战应用——高相关度数据的筛选与利用

掌握“相关度”的实战应用,才能将数据洞察转化为实实在在的行动力。第一步是设定筛选阈值。根据具体任务的容错率,将“相关度”作为筛选条件,例如设定为“大于80%”,快速生成一个高质量的候选短列表。第二步是进行模式分析。深入观察这些高相关度条目的共性,它们是否共享某些特定的长尾关键词、具备相似的内容结构(如清单体、深度教程),或出自同一类型的权威来源?这些模式本身就是极具价值的策略信息。第三步是指导内容产出。基于分析结果,可以精准规划内容矩阵,填补高相关度但竞争较少的蓝海领域,或以更优的形式切入高相关度的红海市场。例如,发现“如何提升B2B客户生命周期价值”相关度极高,但多为理论文章,那么创作一个包含实际案例和工具包的深度指南,便能形成差异化优势。这一系列操作,将“相关度”从一个静态的数字,变成了驱动业务增长的动态引擎。

四、实战指南:如何应用“相关度”进行初步筛选

面对信息洪海或海量选项,“相关度”是最高效的筛选利器。它并非模糊的感觉,而是一套可量化、可执行的标准。掌握其应用方法,能让你在第一时间剔除无效信息,将精力聚焦于核心价值区。本指南将提供一个三步走的实战框架,助你精准、快速地完成初步筛选。

1. 第一步:定义你的“相关度”核心标准

筛选的前提是拥有清晰的标尺。在开始任何筛选工作前,必须首先明确“相关”的具体内涵。这个定义必须紧密围绕你的最终目标,并具备可操作性。

首先,进行目标拆解。你的最终目的是什么?是招聘一名数据分析师,是寻找一篇关于“生成式AI在教育领域应用”的权威报告,还是为你的产品筛选潜在供应商?将宏观目标拆解为具体的关键词、技能、属性或指标。例如,招聘数据分析师,核心标准可能包括“掌握Python/R”、“熟悉SQL数据库”、“具备数据可视化能力”等硬性指标,以及“沟通能力强”等软性素质。

其次,建立筛选清单。将拆解出的要素转化为一个分层级的清单。明确哪些是“必须项”,即一票否决的硬性门槛;哪些是“加分项”,即在满足基本要求后能提升优先级的要素。这个清单将你的主观判断客观化,避免了筛选过程中的随意性和偏见。例如,在筛选供应商时,“ISO9001认证”可以是必须项,而“行业内有成功案例”则是加分项。这个清单就是你的“相关度”度量衡。

2. 第二步:运用“漏斗模型”进行分层筛选

有了清晰的标准,下一步便是构建一个高效的筛选流程。漏斗模型是理想的工具,它能确保你从最宽泛的范围开始,逐步聚焦,避免过早陷入细节。

在漏斗顶层,进行快速淘汰。运用你清单中的“必须项”进行第一轮批量筛选。这一轮追求的是速度和广度。无论是筛选简历、文献还是产品,只要不满足最核心的硬性要求,立即排除。例如,在文献检索中,通过标题和摘要快速判断,剔除所有与核心关键词无关的条目。此阶段的目标是将候选池从一个巨大的数字缩减到一个可控的范围。

进入漏斗中层,进行精准匹配。此时,候选对象已具备基本的相关性。你需要引入“加分项”和更细致的标准进行比较。可以运用关键词密度、概念关联度分析等方法,量化每个选项与目标的契合度。例如,对比两位都通过了初筛的候选人,深入考察其项目经验与岗位需求的匹配程度,或对几篇核心文献进行全文精读,评估其论点、数据对你研究的支撑力度。

3. 第三步:警惕“相关度”的认知陷阱

在应用相关度时,必须警惕几个常见的思维误区,以免错失良机或将精力浪费在“伪相关”上。

要避免“关键词陷阱”。仅凭关键词匹配来判断相关度是片面的,必须理解其背后的语境和语义。一份简历可能堆砌了各种时髦词汇,但缺乏实际项目支撑,其真实相关性微乎其微。

要克服“确认偏误”。不要只寻找那些符合你既有预期的信息。有时,看似不相关的领域或观点,可能蕴含着突破性的机会。保持适度的开放性,在筛选清单之外,留出少量精力审视那些“意外”的选项。

最后,别忘了将“时效性”和“权威性”纳入相关度考量。一篇十年前的技术文章,即使主题完全一致,其参考价值也可能大打折扣。一个来自匿名博客的观点,与一位行业权威的论断,其权重也截然不同。真正的相关度,是主题、质量、时间与来源的综合体。

五、进阶技巧:如何确定最适宜的相关度阈值?

在信息检索、推荐系统或数据匹配任务中,设定相关度阈值是一个至关重要且充满挑战的环节。阈值过高,会导致结果过少,错失潜在的关联项,造成“漏判”;阈值过低,则会产生大量冗余和错误信息,形成“误判”。最适宜的阈值并非一个普适的魔法数字,而是需根据具体业务目标、数据特性与成本考量,通过系统性方法科学确定。以下将介绍一套从理论到实践的进阶流程。

1. 第一步:定义目标并构建验证集

一切量化分析的前提是拥有一个可靠的“标尺”。在讨论阈值之前,必须首先明确“相关”在当前场景下的具体定义。是“用户会点击的商品”?是“属于同一实体的记录”?还是“可能存在风险的交易”?定义越清晰,后续评估越精准。基于此定义,需要从真实业务数据中抽取一个具有代表性的样本,并进行人工标注,构建一个金标准验证集。标注工作应由领域专家或经过严格培训的标注员完成,并通过计算标注者间一致性来确保质量。这个验证集是衡量不同阈值效果的唯一客观依据,没有它,所有讨论都将是空中楼阁。

2. 核心方法:基于精确率与召回率的权衡

有了验证集,我们便可以量化评估不同阈值下的模型表现,核心工具是精确率和召回率。精确率衡量的是系统返回的结果中,真正相关的比例,代表“查准率”;召回率衡量的是所有真正相关的项中,被系统成功找出的比例,代表“查全率”。二者通常呈现负相关关系:提高阈值,精确率上升,召回率下降;降低阈值,召回率上升,精确率下降。为了直观地观察这种权衡,可以绘制Precision-Recall(PR)曲线。曲线上的每一点代表一个阈值下的(P, R)值。最理想的阈值点通常位于曲线的“膝盖”位置,即在不牺牲过多精确率的前提下,召回率获得显著增长的拐点。若需单一指标进行决策,可以采用F1-Score(精确率和召回率的调和平均数),最大化F1-Score对应的阈值通常被视为一个均衡的选择。若业务更侧重某一方面(如风控场景更看重高召回率),可采用加权版的Fβ-Score(β>1侧重召回,β<1侧重精确率)来指导选择。

3. 实践检验:结合业务场景的A/B测试与迭代

离线指标(如F1-Score)提供了强有力的理论依据,但模型的最终价值体现在线上业务效果中。因此,通过离线分析筛选出2-3个候选阈值后,必须进行线上A/B测试。将用户流量随机分配到不同阈值策略的实验组中,观察并对比关键业务指标(KPIs)。例如,在推荐系统中,KPI可能是点击率(CTR)、转化率或用户停留时长;在数据去重场景中,KPI可能是人工审核成本和错误率的平衡。A/B测试能真实反映阈值调整对用户行为和商业目标的最终影响,其结果往往比单纯的离线评估更具说服力。最后,阈值的确定并非一劳永逸。随着数据分布的漂移、业务逻辑的变迁或模型算法的升级,原有的最优阈值可能不再适用。必须建立一个持续监控和定期迭代的机制,确保阈值始终与业务目标保持动态对齐。

六、组合拳玩法:“相关度”与搜索量、竞争度的协同应用

在SEO实战中,孤立地看待任何单一指标都是片面的。真正的效率提升,源于将“相关度”、“搜索量”与“竞争度”三者融合,打出精准的组合拳。这套方法论的核心,是利用“相关度”划定战场,再用“搜索量”与“竞争度”选择战术,最终实现资源的最优配置。

1. 第一步:以“相关度”为基石,筛选核心关键词池

“相关度”是所有策略的起点和底线,它决定了流量的价值。一个与业务核心无关的高搜索量词,带来的流量只能是无效流量,浪费服务器带宽与运营精力。因此,首要任务是建立严格的“相关度”筛选标准。这不仅是关键词字面意思的匹配,更是对用户深层意图的洞察。例如,对于一家企业SaaS软件公司,“如何提升团队协作效率”比“团队”这个词相关度更高,前者直指痛点,后者过于宽泛。执行时,应围绕产品/服务的核心功能、目标用户场景、解决方案等维度,构建一个初步的关键词群,然后毫不留情地剔除所有意向模糊、业务关联弱的词汇。最终得到的,是一个高纯度的、值得投入资源进行后续分析的“核心关键词池”,这是保证后续所有工作不偏离航向的基石。

2. 第二步:“搜索量”与“竞争度”的博弈与权衡

在确立了高相关度的关键词池后,“搜索量”与“竞争度”便成为决策的两大坐标轴,它们共同构成了一个战略机会矩阵。理想的目标是“高搜索量、低竞争度”的“蓝海词”,这类词应作为最高优先级,迅速配置内容资源,抢占排名先机。其次是“高搜索量、高竞争度”的“红海词”,这类词是行业流量的制高点,但需要强大的域名权重和持续的资源投入。对于新站或权重较低的网站,不应直接硬碰,而是选择其下的长尾变体词作为切入点,逐步累积权重。最后,“低搜索量、低竞争度”的“长尾词”虽然单次流量有限,但转化率往往极高,且数量庞大,是构筑主题权威性、获取精准客户的利器。通过这种矩阵分析,可以清晰地看到每个关键词的投入产出比,从而制定出差异化的内容策略,避免将所有资源都砸在竞争最激烈的单一战线上。

3. 第三步:构建“关键词-内容”匹配矩阵,精准狙击

协同应用最终要落地到具体的内容生产。基于前两步的分析,我们可以构建一个“关键词-内容”匹配矩阵。将“蓝海词”对应为核心专题或深度指南,以最优质的内容力求快速排名;将“红海词”的长尾变体规划成系列博客文章或FAQ,形成内容集群,侧面围攻核心词;将“高转化长尾词”制作成产品对比页、客户案例或解决方案详情页,直接承接商业意图。这种矩阵式管理,确保了每一篇内容都有其明确的战略目标——或是为了短期流量爆发,或是为了长期权重积累,或是为了即时转化。它将抽象的SEO数据,转化为可执行、可衡量、可优化的内容行动纲领,让每一次创作都成为一次精准的流量狙击。

七、高相关度 vs. 广泛词:不同策略下的取舍

1. 高相关度词:精准狙击,追求转化

高相关度词,通常指代长尾关键词,其搜索量相对较低,但用户意图极为明确。例如,“适用于扁平足的男士缓震跑鞋”相较于“跑鞋”,前者直接锁定了具有特定痛点和需求的消费群体。这类关键词的核心价值在于捕获购买决策链末端的用户,他们的转化路径最短。投放高相关度词,意味着更低的单次点击成本(CPC)、更高的点击率(CTR)和最终的转化率。对于预算有限、追求快速见效或深耕细分市场的企业而言,这是实现高ROI的利器。策略上,应围绕产品核心功能、用户痛点及应用场景构建词库,确保广告内容和落地页与关键词高度匹配,以“精准”换取“成交”。

2. 广泛词:撒网捕鱼,构建品牌

广泛词,即短尾关键词,如“手机”、“营销”,拥有巨大的搜索流量,是品牌曝光和市场教育的绝佳入口。其用户意图模糊,可能处于信息搜集、品牌比较的早期阶段,直接转化率较低,且竞争激烈,导致广告成本高昂。然而,其战略意义在于“广度”。通过投放广泛词,品牌能够触达海量潜在用户,建立心智认知,为未来的销售转化培育温床。此策略更适合处于扩张期、预算充足且希望提升品牌声量的企业。它不以即时转化为首要目标,而是着眼于长期的品牌资产积累和市场占有率提升,用“规模”换取“未来”。

3. 策略融合:动态平衡的艺术

真正的营销高手从不做单选题,而是在高低之间寻找最佳平衡点。理想的策略是二者的融合,形成营销漏斗的闭环。在预算分配上,可采用“核心-辐射”模型:将大部分预算(如70%)投入到高相关度词上,保障核心转化和现金流;同时,将部分预算(如30%)用于广泛词的品牌曝光活动,持续为漏斗顶层注入新鲜流量。这种配比并非一成不变,需根据业务周期、竞争格局和营销目标动态调整。新品上市期,可侧重广泛词引爆声量;销售冲刺期,则应集中火力于高相关度词收割成果。通过数据分析持续监控不同词群的表现,优化投放策略,才能在精准与规模之间游刃有余,实现短期盈利与长期增长的和谐统一。

八、避坑指南:过度依赖“相关度”的潜在风险

在数据驱动的决策时代,“相关度”分析因其直观性和易得性,已成为商业洞察、市场预测和产品优化的常用工具。然而,当我们将相关度奉为圭臬,甚至将其等同于因果关系时,便踏入了一个充满风险的思维陷阱。过度依赖相关度,不仅可能导致对事实的误读,更会引发战略层面的严重误判。本指南旨在揭示其潜在风险,并提供突围路径。

1. 从“相关”到“因果”的思维陷阱

相关度分析的核心价值在于揭示两个或多个变量之间“同向变化”的趋势,但它完全不回答“为何”会如此。这是相关性与因果关系的本质区别。例如,数据显示某城市冰淇淋销量与溺水人数呈高度正相关,但显然不是吃冰淇淋导致了溺水。真正的驱动因素是“气温升高”这一第三变量:天热,吃冰淇淋的人多,去游泳的人也多。若决策者误将相关性当作因果性,可能会得出“限制冰淇淋销售以减少溺水”的荒谬结论。在商业实践中,这种混淆更为隐蔽。例如,发现投放广告的时段与销售额高度相关,便断定是广告直接拉动了销量,却忽略了可能该时段本身就是消费高峰。这种思维捷径,让我们止步于表象,错失了对商业本质的深层理解。

2. 被忽略的“第三变量”与战略误判

许多看似强大的相关度背后,都潜藏着未被观察的“第三变量”(即混杂变量),它才是驱动变化的真正引擎。过度依赖表观相关,会使企业将资源错误地投入到表征上,而非根本原因,从而造成战略资源的巨大浪费。试想,一款社交App发现,使用“虚拟形象”功能的用户,其日均使用时长和付费率显著高于其他用户。产品团队可能会因此决定大力推广和优化该功能,认为它是提升用户粘性的关键。然而,真正的第三变量可能是“用户的社交活跃度与归属感”。正是那些本身就高度投入、乐于在社区中表达的用户,才倾向于使用虚拟形象这类深度互动功能。此时,虚拟形象只是高价值用户行为的“结果”,而非“原因”。若公司倾尽资源去优化一个结果,而忽略了去构建能提升用户归属感的社区生态和互动机制,那么战略方向已然跑偏。

3. 如何突围:构建多维验证体系

要摆脱对相关度的过度依赖,关键在于建立一个超越简单相关分析的、多维度的验证体系。首先,必须保持批判性思维,对任何显著的相关性追问“为什么”,并尝试构建合理的因果逻辑链条。其次,主动寻找并控制潜在的混杂变量。在数据分析中,可以运用多元回归等统计方法,剥离其他因素的影响,更纯粹地评估变量间的关系。最后,也是最重要的一步,是引入实验性验证。通过A/B测试、对照实验等方法,在严格控制其他变量的前提下,主动干预某一变量,观察另一变量是否发生预期变化。例如,想要验证广告效果,就应进行随机分组测试,而非简单比较投放前后的数据。只有通过这种“假设-验证”的闭环,我们才能从“数据相关”的观察者,升级为“洞察因果”的决策者,真正让数据服务于精准有效的战略制定。

九、案例剖析:从海量词库到精准长尾词的筛选流程

在SEO实践中,拥有一个庞大的关键词词库只是起点,而非终点。真正的挑战在于如何从成千上万个词汇中,精准地筛选出能够带来精准流量、具备高转化潜力的长尾关键词。本章将以一个“出国留学语言培训”业务为例,剖析一套从海量到精准的系统化筛选流程,确保每一步都目标明确、数据驱动。

1. 海量词库的构建与初步清洗

筛选流程的第一步是建立一个尽可能全的初始词库,然后进行初步的“去噪”处理。

首先,以核心业务词“雅思培训”为种子词,利用多种渠道进行拓展。这包括:

1. 工具挖掘:使用关键词规划工具(如5118、Ahrefs),输入种子词,获取其推荐的相关词、问句词和同义词。

2. 竞品分析:分析排名靠前的竞争对手网站,提取他们正在优化的页面标题、Meta描述及内容中的核心关键词。

3. 平台数据:抓取知乎、Bilibili、小红书等平台中与“雅思”相关的热门话题、文章标题和用户搜索建议。

此时,我们可能会得到一个包含数万甚至十万级词汇的庞大数据集。初步清洗的目标是剔除明显无效的词汇,例如:

* 重复词与高度相似词:合并“雅思培训班”与“雅思培训课程”等意义高度重合的词。

* 品牌词与无关词:去除竞品品牌名,以及与业务无关的词汇(如“雅思考试成绩查询时间”这类纯信息查询词,商业价值低)。

* 极端数据词:暂时过滤掉月搜索量为0或竞争难度(KD值)极高的词汇,为后续分析减负。经过此步,词库规模可缩减10%-20%,变得更为“干净”。

2. 多维度筛选:数据驱动与用户意图分析

这是整个流程的核心,我们通过量化指标与定性分析相结合的方式进行深度筛选。

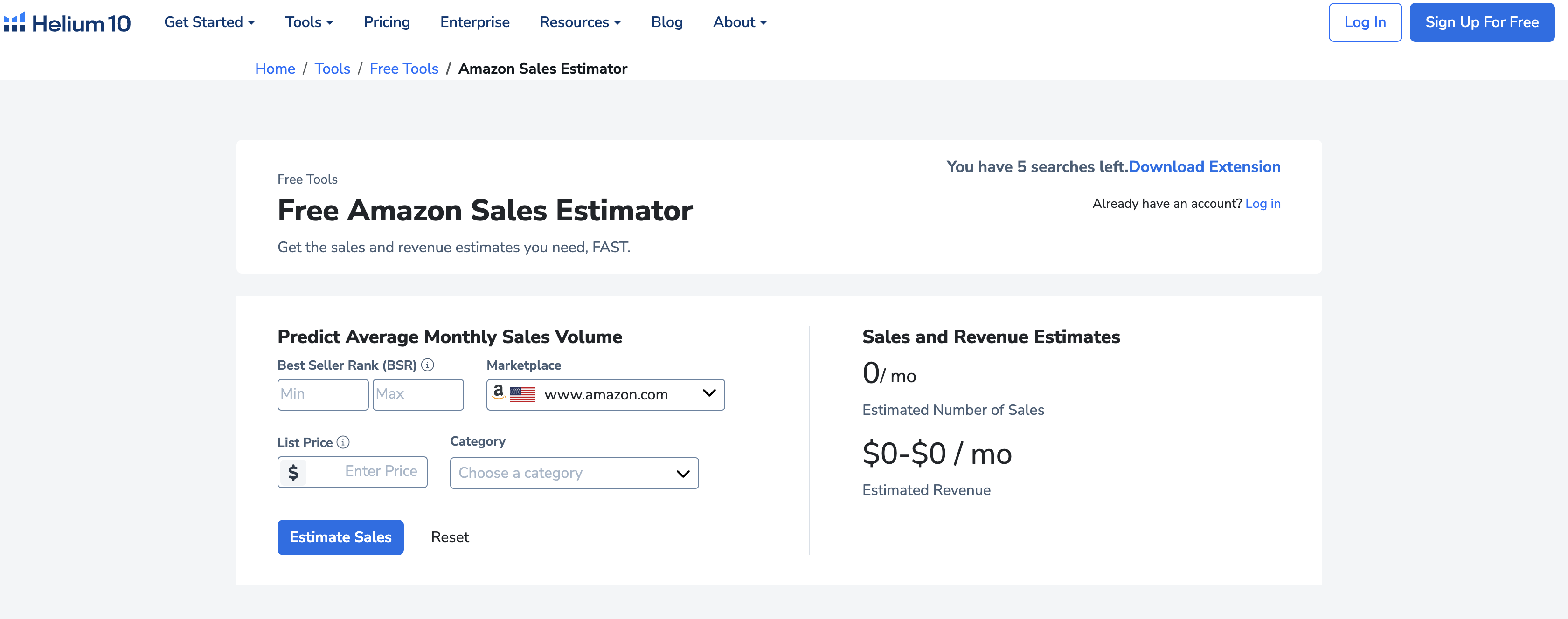

数据维度是硬性标准。我们设定以下阈值来过滤词库:

* 搜索量:锁定月均搜索量在100-1000区间的词汇。搜索量过低无流量价值,过高则往往竞争激烈,不适合作为长尾词的突破口。

* CPC(单次点击成本):优先选择CPC高于5元的词汇。高CPC通常意味着该词的商业价值高,广告主愿意为其付费,转化潜力更大。

* 关键词难度(KD):聚焦KD值低于30的词汇。这确保我们有机会通过优质内容获得较好的排名。

用户意图维度是筛选的灵魂。我们将词汇分为四类:

* 信息型:“雅思阅读如何提高”

* 导航型:“雅思官网”

* 交易型:“北京雅思培训机构价格”

* 商业调研型:“环球雅思和新东方雅思哪个好”

在本案例中,我们的目标是获取销售线索,因此重点保留商业调研型和交易型的长尾词。例如,经过多维度筛选,“北京海淀区雅思一对一辅导价格”这个词就完美符合要求:搜索量适中、CPC较高、KD值低,且用户意图明确指向付费决策。

3. 价值验证与内容映射

筛选出候选词列表后,最后一道工序是进行价值验证,并将其与具体内容形式一一对应。

价值验证主要通过SERP(搜索引擎结果页)分析来完成。逐一搜索候选词,考察排名前三的页面类型。如果结果多为机构官网、课程详情页或高质量的对比评测文章,说明该词的商业生态成熟,值得投入。反之,若充斥着无关的论坛帖子或低质量内容,则需谨慎。

内容映射则是将词库“变现”的关键。我们将最终确认的长尾词进行主题聚类,并为每个主题规划对应的内容资产。例如:

* 将所有关于“价格”的长尾词(如“雅思网课一般多少钱”、“雅思VIP课程收费标准”)整合,撰写一篇详尽的《2024年雅思培训课程价格全解析》博客文章。

* 将关于“机构对比”的词(如“A机构和B机构雅思口语课哪个好”)制作成专题对比页面或视频。

通过这一流程,我们将一个庞大的原始词库,最终转化为数十个目标明确、商业价值高、且已规划好具体承载内容的精准长尾词,为后续的SEO内容策略提供了清晰的作战地图。

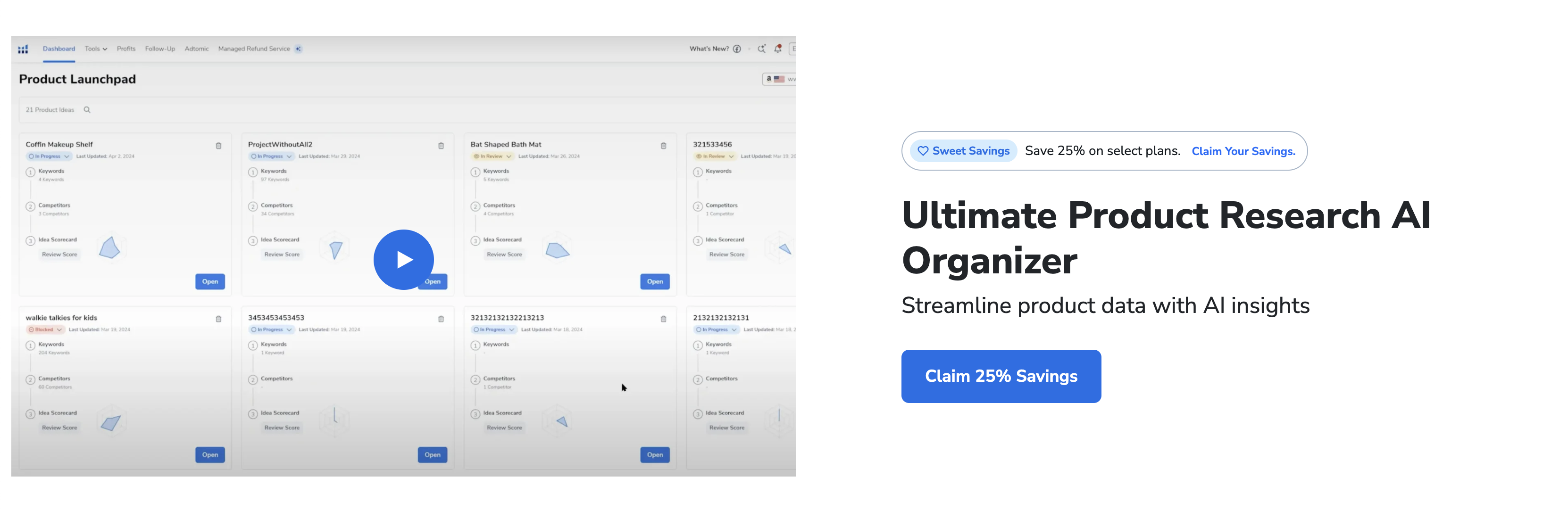

十、筛选之后:如何将高相关度词融入 Listing 优化

经过严密的数据分析与市场比对,我们已筛选出一组高相关度、高转化的关键词。然而,这份列表的价值并非在于其本身,而在于如何将其精准、自然地融入到产品Listing的每一个角落,从而实现搜索权重的最大化与转化率的提升。以下将分步解析关键词的落地策略。

1. 标题与五点描述:权重最高的关键词阵地

标题和五点描述是亚马逊算法和消费者最先关注的部分,是关键词权重的核心区域,必须优先布局。

标题优化:遵循“核心前置,属性补充”的原则。将最重要的核心关键词(通常1-2个)放置在标题最前端,紧随其后的是产品的关键属性词、功能词或使用场景词。例如,对于一个“便携榨汁杯”,其核心关键词是“portable blender”,标题可以这样构建:“Brand Name Portable Blender, 20oz USB Rechargeable Juicer Cup for Smoothies and Shakes, BPA-Free...”。这种结构既保证了算法的抓取效率,也让用户在第一时间就能识别产品核心价值。切忌关键词堆砌,确保标题的可读性与营销吸引力。

五点描述优化:五点描述是产品的“迷你说明书”和“卖点放大器”。每一条都应以一个提炼核心卖点的短语开头,并大写首字母以突出重点。在具体阐述中,将筛选出的长尾关键词和属性词有机地织入文案中。例如,在描述“续航能力强”这一点时,可以融入“long-lasting battery”、“single charge for 15 cups”、“ideal for travel, gym, office”等词组。关键在于,五点描述中的关键词应与标题中的核心关键词形成互补关系,覆盖更广泛的搜索意图,如材质、尺寸、人群、兼容性等,而不是简单重复。

2. 产品描述与A+内容:构建场景与补充长尾词

当消费者被标题和五点吸引后,他们会进一步查看产品详情,这是建立信任、激发购买欲望的关键环节。

产品描述(Description):对于没有A+权限的卖家,这里是补充长尾关键词的黄金地带。应采用段落式叙述,将无法自然放入标题和五点的词语,通过场景化描述进行渗透。例如,可以描述“使用这款榨汁杯制作宝宝辅食的便捷性”或“在办公室快速补充能量的体验”,从而引入“baby food maker”、“office blender”等长尾词。逻辑清晰、可读性强的描述能有效提升用户停留时间,间接影响排名。

A+内容(Enhanced Brand Content):A+内容中的文本同样能被亚马逊索引,虽权重略低于普通描述,但其图文并茂的形式对转化率提升巨大。应在A-模块的标题和简短文案中,植入次要关键词和场景词。例如,在展示产品的清洗方式时,可使用“Easy to Clean & Dishwasher Safe”作为标题,既传达了卖点,又覆盖了相关搜索。A+的核心在于用视觉语言强化产品优势,关键词的融入需服务于这一目标,做到画龙点睛而非喧宾夺主。

3. 后端关键词:隐蔽的流量补漏网

后端关键词是Listing优化的最后一道防线,用于捕获那些因语法、拼写、同义词等原因未能被前端覆盖的搜索流量。填写时必须遵守严格规则:不重复使用前端已出现的词、不使用品牌名或竞品ASIN、无标点符号、空格隔开。重点填充同义词(如sofa vs couch)、常见拼写错误(如blender vs blander)、缩写以及各类组合词。充分利用这249个字符的空间,构建一个无形的流量捕捉网,确保任何潜在的搜索需求都不会被遗漏。

十一、反向思考:利用低相关度词发现新蓝海市场

在流量成本日益高昂的今天,固守核心关键词的营销思维无异于在红海中肉搏。真正的增长机会,往往隐藏在那些看似无关的“低相关度词”背后。通过反向思考,将这些被忽视的搜索信号转化为商业洞察,是开辟蓝海市场的关键路径。

1. 超越核心关键词:低相关度词的隐性价值

传统营销聚焦于“跑鞋”、“降噪耳机”这类高流量、高转化的核心词,但这片区域早已是巨头林立、竞争白热化的红海。低相关度词,指的是那些与产品本身没有直接关联,却反映了用户特定生活场景、潜在焦虑或衍生需求的搜索词。例如,用户搜索“久坐后腰疼如何缓解”,与跑鞋看似无关,却精准描绘了一个“办公室久坐人群”的画像及其痛点。这些词语是用户需求的“原始数据”,未被过度开发和定义,蕴含着巨大的市场潜力。它们不指向现有产品,而是指向一个未被满足的“问题”。

2. 挖掘方法:从用户情境与痛点中捕获信号

发现低相关度词不能依赖传统关键词工具,必须深入用户的真实世界。首先,要扎根用户社区,如知乎、Reddit、垂直论坛,观察用户在抱怨什么、讨论什么“无用”的细节。其次,系统分析客服与售后数据,用户最常提出的“偏门”问题就是最佳线索。例如,购买高端厨具的用户频繁咨询“如何清洁大理石台面”,这就暴露了清洁需求的缺口。最后,利用搜索引擎的“相关搜索”和问答平台,围绕你的核心用户身份(如“新手妈妈”、“程序员”)进行发散式搜索,捕获那些意料之外的关联词汇,它们就是通往新世界的路标。

3. 价值转化:从陌生词汇到蓝海产品的路径

捕获信号后,核心任务是“场景重构”,将词语还原为具体的生活画面,并以此为基础进行产品或服务创新。例如,一家运动品牌发现,除了“跑鞋”,用户还在高频搜索“马拉松赛后恢复”、“办公室午休如何放松”。这揭示了用户需求的延伸:从“运动中”扩展到“运动后”和“非运动场景”。基于此,该品牌不必再纠结于跑鞋性能的微创新,而是可以开辟一条全新的产品线——运动恢复系列,推出便携筋膜枪、恢复拖鞋、甚至与办公家具品牌合作开发“动态办公椅”。此举直接切入了一个竞争稀疏、需求明确的蓝海市场,从一个产品制造商转型为生活方式提供者,重新定义了品牌边界。

- 我的微信

- 这是我的微信扫一扫

-

- 我的微信公众号

- 我的微信公众号扫一扫

-